Marketingkampagnen müssen fortlaufend optimiert werden. Hier kann A/B-Testing helfen. Doch wann liefern Experimente tatsächlich brauchbare Ergebnisse? Und wann sind sie reine Zeitverschwendung?

Was ist A/B Testing?

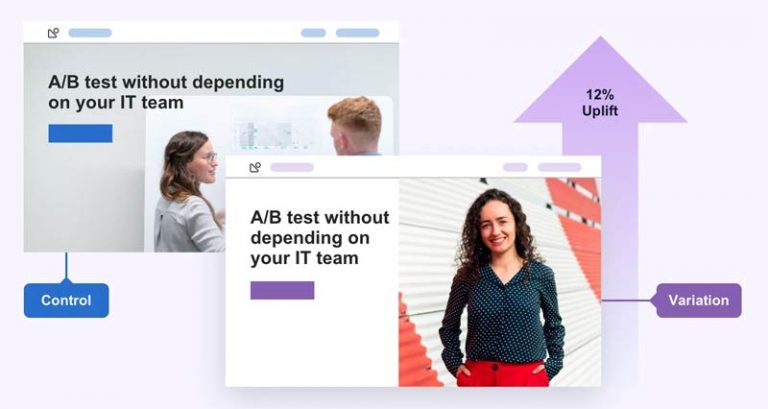

A/B Testing (auch bekannt unter A/B/n Test, AB Test, Split Test, …) ist ein bewährtes Verfahren für direkte Leistungsvergleiche. Das Prinzip: Zwei verschiedene Varianten (z. B. Texte oder Grafiken) ausspielen und prüfen, welche besser performt. Beim “Gewinner” geht man davon aus, dass dieser den größten Erfolg verspricht.

Besonders verbreitet sind A/B Testings im Performance Marketing und im E-Mail-Marketing. Doch längst werden Online-Experimente auch auf E-Commerce-Shops und Landingpages angewendet.

Wissenschaftlich betrachtet gehört der A/B Test zu den sogenannten Feldexperimenten. Anders als in Laborexperimenten wird unter realen Bedingungen durchgeführt. Er gilt unter Statistikern deshalb als Goldstandard.

Automatisiertes A/B Testing

Online-Experimente sind zeitaufwendig. Im E-Mail-Marketing und in der Online-Werbung haben sich deshalb schon längst automatisierte A/B Tests etabliert: Der Gewinner eines abgeschlossenen Tests wird hier automatisch für die Kampagne verwendet. Zum Beispiel die Betreffzeile einer E-Mail im Rahmen eines Newsletter-Versands. Manuelles Eingreifen ist nicht nötig.

Überwachte A/B Tests

Automation ist längst nicht überall möglich. Am Ende eines überwachten Tests muss der zuständige Marketing Manager bzw. Digital Analyst entscheiden, ob der Gewinner genutzt wird oder zunächst weitere Tests mit neuen Varianten gefahren werden sollen. Überwachte Tests werden häufig auch vorzeitig abgebrochen.

Vor- und Nachteile von A/B Testing

Vorteile

Ein A/B Test ist mit den entsprechenden Tools relativ “einfach” umsetzbar. Daraus resultiert jedoch auch ein großes Risiko: Falsch umgesetzte A/B Tests können ein Marketing Team mit einer Vielzahl irreführender “Erkenntnisse” fluten, die in der Folge zu falschen Entscheidungen führen.

Nachteile

Conversion-Optimierung auf Basis von A/B Testing setzt voraus, dass auf ausreichend viele Live-Daten zurückgegriffen werden kann. Anders ausgedrückt: Je weniger Website Traffic und je weniger Conversions, desto langwieriger und schwieriger sind aussagekräftige Experimente.

Darüber hinaus ist der Weg hin zu einem brauchbaren Testergebnis gesäumt von Fallstricken. Nur wer die alle kennt und mit Widrigkeiten umgehen kann, ist vor Fehlschlüssen gewappnet.

In dem Zusammenhang hier eine Buchempfehlung:

Trustworthy Online Controlled Experiments: A Practical Guide to A/B Testing

Tipps für korrektes A/B Testing

1) Achte auf ein gutes Testdesign!

Ohne korrekte Planung kaum brauchbare Testergebnisse. Lege deshalb viel Wert auf ein gut durchdachtes Testdesign. Dazu gehören Fragestellung nach der zu untersuchenden Einheit und dem zu untersuchenden Segment. Dazu kommt die Festlegung des angestrebten Uplifts, der statistischen Signifikanz und schließlich der Hypothese.

Statistische Signifikanz

Bei einem A/B Test sollte der Unterschied mehr als das Doppelte der Quadratwurzel der Gesamtmenge betragen. Beispiel:

A bringt 50.000 Klicks

B bringt 40.000 Klicks

Summe = 90.000

Differenz= 10.000

Die doppelte Quadratwurzel der Summe beträgt 600.

Die doppelte Quadratwurzel der Differenz beträgt 200.

600 > 200

Resultat: Das Ergebnis ist signifikant, d.h. der Test ist aussagefähig – und A ist der Gewinner.

Stichwort Segment: Experimente sind wenig aussagekräftig, wenn die Struktur der zu untersuchenden User heterogen ist. Du verkaufst, ähnlich wie amazon oder Netflix an alle möglichen Zielgruppen? Dann ist die Bildung von Segmenten unverzichtbar. Mehr zum Thema findest du in diesem Artikel von Yaniv Navot: Segmented A/B tests: Avoiding average experiences

2) Überprüfe jedes Ergebnis!

Kausalität gibt es ohne Korrelation. Überprüfe das Ergebnis also immer auf weitere Einflussfaktoren. Lädt eine der Varianten langsamer? Gibt es Differenzen in den Wochentagen? Was ist mit wiederkehrenden Usern? Was ist mit Usern ohne Cookie Consent? Tatsächlich ist die Realität meistens viel komplexer als angenommen. Hilfreich kann zum Beispiel ein sogenannter A/A Test sein.

3) Erspare dir Tests für das eigene Ego!

A/B Testing ist nicht dazu da, eine Meinung durchzusetzen. Testergebnisse dienen allein dem Erkenntnisgewinn. Persönliches Ego und Bauchgefühl haben mit Data-Driven Marketing nichts zu tun.

4) Vermeide Risiken mittels Ramp-ups!

Ist die zu testenden Variante mit Risken verbunden? Dann macht es Sinn, sie vor dem eigentlichen Experiment innerhalb eines kleineren Segments zu testen.

5) Verändere eine Variation möglichst nur an einer Stelle!

Veränderst du in der Variante sowohl eine Headline als auch eine Grafik, weißt du am Ende nicht, was den möglichen Uplift verursacht hat. Zumal sich verschiedene Änderungen auch untereinander beeinflussen können. Teste deshalb möglichst immer nur kleine Änderungen, wenn du etwas lernen möchtest.

Vorsicht

A/B Tests kosten immer Geld. Ganz besonders schlechte Tests, welche potenzielle Kunden von einem Kauf abhalten. Du tust dich schwer mit explorativer Statistik? Dann lass die Finger davon!

6) Sei vorsichtig mit Automation von KI-Inhalten!

Immer öfter werden Large Language Models (LLMs) eingesetzt, um Text- und Bildvarianten automatisch zu generieren und einem Test zuzuführen. Das klingt toll, aber geht an den eigentlichen Problemen vorbei. Vor allem aber ist Vorsicht geboten, denn KI kann nicht die Qualität einer Variante bewerten. Manuelles Überprüfen ist also weiterhin unverzichtbar.

Viel Potenzial liefert hingegen der Einsatz von Analytical AI. Zum Beispiel im Rahmen prädiktiver Modelle.

Tools für A/B Testing

Für die Optimierung von Webseiten, Shops und Apps wird eine Vielzahl spezieller Tools angeboten. Die Bekanntesten sind:

Fazit

Sauberes A/B Testing ist komplexer, als viele wahrhaben wollen. Das Problem: Nicht korrekt durchgeführte Experimente locken einen auf die falsche Fährte und verschlingen unterm Strich mehr Geld, als sie einbringen. Richtig umgesetzt liefert ein A/B Test jedoch wertvolle Erkenntnisse.

Ergänzende Artikel

Moin aus Hamburg!

Mein Name ist Frank und ich bin bereits seit Mitte der 1990er in der Digitalbranche unterwegs. Meine Schwerpunkte sind Content-Marketing, Marketing Automation und MarTech.