Der Mensch ist von Natur aus wissbegierig, möchte beobachten, entdecken, erfahren und dieses Wissen weitergeben. Ein Grund, warum A/B-Tests im Digitalmarketing so beliebt sind. Aber liefern sie tatsächlich valide Ergebnisse?

Was ist ein A/B Test?

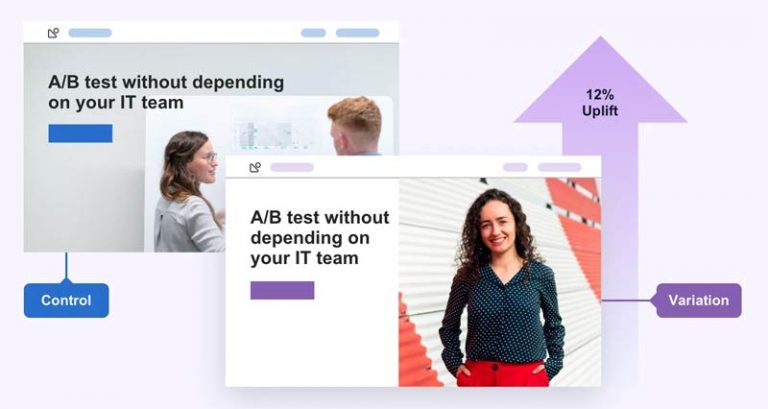

Der A/B Test (auch bekannt unter A/B/n Test, AB Test, Split Test, ABTest, …) ist ein bewährtes Verfahren für direkte Leistungsvergleiche. Das Prinzip: Zwei verschiedene Varianten (z. B. Texte oder Grafiken) ausspielen und prüfen, welche besser performt. Beim “Gewinner” geht man davon aus, dass dieser den größten Erfolg verspricht.

Besonders verbreitet sind A/B Tests im Performance Marketing und hier vor allem Advertising und E-Mail-Marketing. Doch längst werden Online-Experimente auch auf E-Commerce-Shops und Landingpages angewendet.

Wissenschaftlich betrachtet gehört der A/B Test zu den sogenannten Feldexperimenten. Anders als in Laborexperimenten wird unter realen Bedingungen durchgeführt. Er gilt unter Statistikern deshalb als Goldstandard.

Automatisierte A/B Tests

Online-Experimente sind zeitaufwendig. Im E-Mail-Marketing und in der Online-Werbung haben sich deshalb schon längst automatisierte A/B Tests etabliert: Der Gewinner eines abgeschlossenen Tests wird hier automatisch für die Kampagne verwendet. Zum Beispiel die Betreffzeile einer E-Mail im Rahmen eines Newsletter-Versands. Manuelles Eingreifen ist nicht nötig.

Überwachte A/B Tests

Automation ist längst nicht überall möglich. Am Ende eines überwachten Tests muss der zuständige Marketing Manager bzw. Digital Analyst entscheiden, ob der Gewinner genutzt wird oder zunächst weitere Tests mit neuen Varianten gefahren werden sollen. Überwachte Tests werden häufig auch vorzeitig abgebrochen.

Vorteile von A/B Tests

Ein A/B Test ist mit den entsprechenden Tools relativ “einfach” umsetzbar. Daraus resultiert jedoch auch ein großes Risiko: Falsch umgesetzte A/B Tests können ein Marketing Team mit einer Vielzahl irreführender “Erkenntnisse” fluten, die in der Folge zu falschen Entscheidungen führen.

Nachteile von A/B Tests

Conversion-Optimierung auf Basis von A/B Tests setzt voraus, dass auf ausreichend viele Live-Daten zurückgegriffen werden kann. Anders ausgedrückt: Je weniger Website Traffic und je weniger Conversions, desto langwieriger und schwieriger sind aussagekräftige Experimente.

Darüber hinaus ist der Weg hin zu einem brauchbaren Testergebnis gesäumt von Fallstricken. Nur wer die alle kennt und mit Widrigkeiten umgehen kann, ist vor Fehlschlüssen gewappnet.

In dem Zusammenhang hier eine Buchempfehlung:

Trustworthy Online Controlled Experiments: A Practical Guide to A/B Testing

Tipps für brauchbare A/B Tests

1) Achte auf ein gutes Testdesign!

Ohne korrekte Planung kaum brauchbare Testergebnisse. Lege deshalb viel Wert auf ein gut durchdachtes Testdesign. Dazu gehören Fragestellung nach der zu untersuchenden Einheit und dem zu untersuchenden Segment. Dazu kommt die Festlegung des angestrebten Uplifts, der statistischen Signifikanz und schließlich der Hypothese.

Statistische Signifikanz

Bei einem A/B Test sollte der Unterschied mehr als das Doppelte der Quadratwurzel der Gesamtmenge betragen. Beispiel:

A bringt 50.000 Klicks

B bringt 40.000 Klicks

Summe = 90.000

Differenz= 10.000

Die doppelte Quadratwurzel der Summe beträgt 600.

Die doppelte Quadratwurzel der Differenz beträgt 200.

600 > 200

Resultat: Das Ergebnis ist signifikant, d.h. der Test ist aussagefähig – und A ist der Gewinner.

Stichwort Segment: Experimente sind wenig aussagekräftig, wenn die Struktur der zu untersuchenden User heterogen ist. Du verkaufst, ähnlich wie amazon oder Netflix an alle möglichen Zielgruppen? Dann ist die Bildung von Segmenten unverzichtbar. Mehr zum Thema findest du in diesem Artikel von Yaniv Navot: Segmented A/B tests: Avoiding average experiences

2) Überprüfe jedes Ergebnis!

Kausalität gibt es ohne Korrelation. Überprüfe das Ergebnis also immer auf weitere Einflussfaktoren. Lädt eine der Varianten langsamer? Gibt es Differenzen in den Wochentagen? Was ist mit wiederkehrenden Usern? Was ist mit Usern ohne Cookie Consent? Tatsächlich ist die Realität meistens viel komplexer als angenommen. Hilfreich kann zum Beispiel ein sogenannter A/A Test sein.

3) Erspare dir Tests für das eigene Ego!

A/B Tests sind nicht dazu da, eine Meinung durchzusetzen. Sie dienen allein dem Erkenntnisgewinn. Persönliches Ego und Bauchgefühl haben mit Data-Driven Marketing nichts zu tun.

4) Vermeide Risiken mittels Ramp-ups!

Ist die zu testenden Variante mit Risken verbunden? Dann macht es Sinn, sie vor dem eigentlichen Experiment innerhalb eines kleineren Segments zu testen.

5) Verändere eine Variation möglichst nur an einer Stelle!

Veränderst du in der Variante sowohl eine Headline als auch eine Grafik, weißt du am Ende nicht, was den möglichen Uplift verursacht hat. Zumal sich verschiedene Änderungen auch untereinander beeinflussen können. Teste deshalb möglichst immer nur kleine Änderungen, wenn du etwas lernen möchtest.

Vorsicht

A/B Tests kosten immer Geld. Ganz besonders schlechte Tests, welche potenzielle Kunden von einem Kauf abhalten. Du tust dich schwer mit explorativer Statistik? Dann lass die Finger davon!

6) Sei vorsichtig mit Automation von KI-Inhalten!

Content Creator lieben LLMs. Viele Markeer nutzen Tools wie Gemini oder ChatGPT zum Generieren von Variationen für ihrer A/B-Tests. Hier ist Vorsicht geboten, denn KI nicht die Qualität der Inhalte bewerten. Es besteht auch die Gefahr, dass völlig ungeeignete Varianten ausgespuckt werden. Manuelles Überprüfen ist folglich unverzichtbar.

Tools für A/B Tests

Für die Optimierung von Webseiten, Shops und Apps wird eine Vielzahl spezieller Tools angeboten. Die Bekanntesten sind:

Diese Tools arbeiten jedoch nicht immer sauber. Vor allem dann nicht, wenn es im Rahmen des Set-ups und bei der Konfiguration zu Fehlern kommt. Und das passiert erstaunlich häufig.

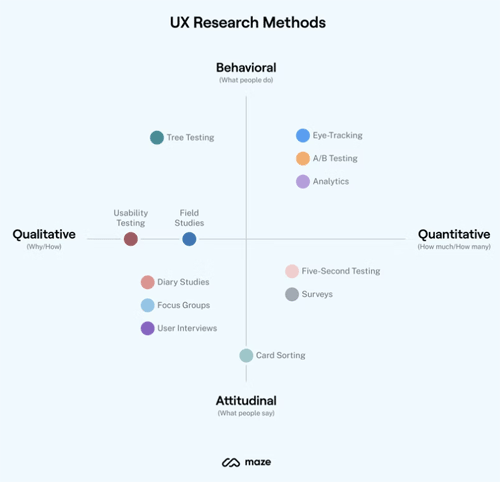

Alternativen zum A/B Test

Nachfolgend ein paar Alternativen zu Online-Experimenten. Übrigens: Oft macht es Sinn, verschiedenen Verfahren miteinander zu kombinieren.

FSBO

Gemäß dem Pareto-Prinzip (80-20-Regel) lässt sich fast jede Websites und jeder Online-Shop auch ohne A/B Tests optimieren. Dazu werden offensichtliche Schwachstellen und Fehler identifiziert und behoben.

Ein auf Pragmatismus setzende Verfahren nennt sich FBSFO (‘Fix broken shit first’ Optimization) und wurde 2021 von Rich Page erstmals erwähnt. Es bringt handfeste Vorteile mit sich:

- Geschwindigkeit: FBSFO lässt sich ohne große Vorbereitungen umsetzen. Anders als korrekt durchgeführte Experimemte, für die schon mal einige Wochen investiert werden muss.

- Unabhängig vom Trafficvolumen: FBSFO ist auch für minimales Traffic geeignet. Also perfekt für B2B-Organisationen und Startups, die nicht über Big Data verfügen.

- Kosten: Ander als CRO ist FBSFO kein kontinuierlicher Prozess. Entsprechend sind die Kosten für Personal und Technologie auch deutlich geringer.

- Sicherheit und Compliance: FBSFO stellt sicher, dass Webseiten und Shops sicher sind und Cookies korrekt setzen.

Das FBSFO-Verfahren ist jedoch ebenfalls nichts für Anfänger. Auch hier sind Skills aus den Bereichen Analytics, UX Design, UX Writing und Frontend Development unverzichtbar.

Quantitative Umfragen

Warum nicht einfach den Kunden fragen? Vor allem Online-Umfragen und Votings lassen sich automatisieren und können wertvolle Insights liefern.

Qualitative Erhebungen

Sofern das Budget es zulässt, sind natürlich auch qualitative Erhebungen eine Alternative zum A/B Test. Dazu wird insbesondere auf Einzelinterviews und Fokusgruppen zurückgegriffen. Quantitative Techniken hingegen sind mit Fragebögen verbunden, und ihr Ergebnis sind Online- oder Offline-Umfragen.

Fazit

Aussagekräftige A/B Tests sind komplex - und nicht korrekt durchgeführte Experimente liefern fehlerhafte Ergebnisse. Sie verschlingen somit mehr Geld, als sie einbringen.

Das Problem: Im Markt für Conversion-Optimierung tummeln sich viele selbst ernannte Experten*innen mit angelesenem Halbwissen. Sofern du auf A/B-Tests nicht verzichten möchtest, stelle sicher, dass die verantwortlichen Akteure sich sehr gut mit Stochastik auskennen.

Ergänzende Artikel

Moin aus Hamburg!

Mein Name ist Frank und ich bin bereits seit 1996 in der Digitalbranche unterwegs. Du benötigst Hilfe bei der Auswahl und Einführung von Tools oder einer Marketing Cloud? Gern bin ich dein unabhängiger MarTech-Berater!